L’analyse de données et l’apprentissage automatique trouvent leur application dans de nombreux domaines des sciences fondamentales – la physique théorique n’y faisant pas exception. Mon équipe à l’Institut de Physique théorique (IPhT) conduit des travaux dans la direction opposée en tirant parti de méthodes initialement développées pour étudier des matériaux, comme les verres ou les aimants désordonnés, afin de comprendre théoriquement des problèmes de science des données et d’apprentissage automatique (machine learning).

Dans l’expression big data, l’adjectif big signifie non seulement qu’un gros disque dur est nécessaire pour stocker les données, mais aussi que la dimensionnalité de chaque point de donnée est grande. Un exemple simple : la régression linéaire. Si deux paramètres suffisent à ajuster une droite à l’ensemble des points de données, les applications actuelles traitent généralement de données où chaque point se trouve dans un espace de grande dimension, et où le nombre de paramètres à déterminer correspond à cette dimension. Une grande partie des défis théoriques en statistique résultent précisément de cette grande dimensionnalité.

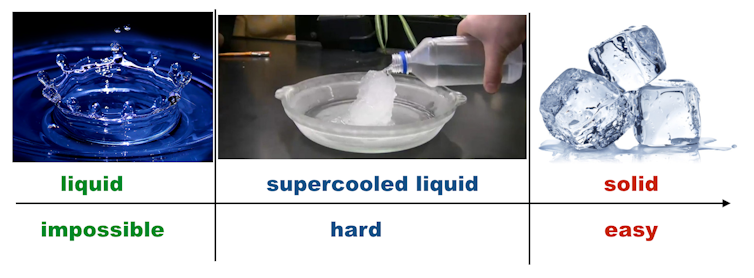

Or, certains modèles étudiés en physique statistique sont mathématiquement équivalents à ceux des statistiques en grande dimension. En science des données, les modèles servent habituellement à guider la conception des algorithmes. En physique, les modèles (souvent les mêmes) sont étudiés, dans une optique un peu plus académique, d’abord pour comprendre leur comportement. En particulier, la physique statistique traite souvent des transitions de phases, c’est-à-dire des changements abrupts de comportement. Or, curieusement, il existe une correspondance étroite entre les phases physiques (liquide, liquide surfondu ou verre, solide) et les régions des paramètres pour lesquelles une tâche spécifique d’analyse de données est algorithmiquement impossible, difficile ou simple. L’identification de ces phases dans divers problèmes de science des données est l’un des principaux objectifs des recherches de mon groupe.

De façon remarquable, cette activité axée sur la compréhension des modèles en soi inspire également le développement de nouvelles classes d’algorithmes. Des exemples développés à l’IPhT incluent la conception de protocoles de mesures d’acquisition comprimée, inspirés par la nucléation en physique, et d’une nouvelle classe d’algorithmes spectraux pour traiter les ensembles de données peu reliés. Actuellement, l’équipe bénéficie d’une subvention de l’ERC Starting Grant pour poursuivre ces recherches en se focalisant sur les différents types de réseaux neuronaux mis en œuvre dans le deep learning.

Cet article est publié en partenariat avec le CEA dans le cadre de la nouvelle formule du magazine Clefs dont le premier numéro, consacré au big data, sera disponible à partir du 15 juin.